El impacto del nuevo chip Ocelot en la computación cuántica: un avance revolucionario en la corrección de errores cuánticos. La computación cuántica está en la cúspide de una revolución tecnológica, pero su desarrollo enfrenta un obstáculo crítico: los errores cuánticos. Estos errores, causados por la fragilidad de los cúbits frente al ruido ambiental, han sido el mayor desafío para construir ordenadores cuánticos funcionales. Sin embargo, un nuevo avance promete cambiar el panorama: el chip Ocelot, desarrollado por AWS en colaboración con Caltech, introduce una innovadora arquitectura basada en cúbits tipo “cat” que reduce drásticamente la tasa de errores. Este avance podría acelerar el desarrollo de computadoras cuánticas que no fallen, capaces de superar los límites de las computadoras tradicionales en campos como la criptografía, la inteligencia artificial y la simulación de materiales. En este artículo, exploraremos qué hace especial al chip Ocelot, cómo funciona su novedoso sistema de corrección de errores y qué impacto podría tener en el futuro de la computación cuántica.

Introducción a la computación cuántica

La computación cuántica es un paradigma de procesamiento de información que explota las leyes de la mecánica cuántica para realizar cálculos de formas imposibles para las computadoras clásicas. En lugar de bits clásicos (0 ó 1), utiliza cúbits (bits cuánticos) que pueden existir en superposición cuántica de estados. Esto significa que un cúbit puede estar en el estado 0 y 1 al mismo tiempo, con ciertas probabilidades para cada uno. Por ejemplo, es como si una moneda estuviera girando sobre sí misma: no es cara ni cruz, sino una mezcla de ambas hasta que se observa. Gracias a la superposición, un conjunto de cúbits puede representar simultáneamente muchas combinaciones de 0 y 1, otorgando un poder de cómputo exponencialmente mayor en ciertos problemas.

Otro fenómeno clave es el entrelazamiento cuántico, una correlación misteriosa que puede vincular dos o más cúbits. Cuando dos cúbits están entrelazados, sus estados quedan conectados de tal forma que medir uno afecta instantáneamente el estado del otro, sin importar la distancia que los separe. Esto permite coordinar cúbits para que operen como una unidad cuántica conjunta: un ordenador cuántico aprovecha el entrelazamiento para realizar operaciones sobre múltiples cúbits de manera más poderosa que cualquier computadora clásica. Estas propiedades –superposición y entrelazamiento– permiten algoritmos cuánticos capaces de resolver ciertos problemas mucho más rápido que los algoritmos tradicionales. Un ejemplo famoso es el algoritmo de Shor para factorizar números enteros, propuesto en 1994, que ejecutado en un computador cuántico podría romper los esquemas criptográficos actuales (como RSA) exponencialmente más rápido que cualquier computadora convencional. Este potencial ha motivado gran expectación en campos que van desde la seguridad informática hasta la simulación de moléculas en química.

Sin embargo, construir computadores cuánticos funcionales es extremadamente desafiante. Aunque ya existen prototipos de procesadores cuánticos con decenas o cientos de cúbits, aprovechar plenamente su potencia requiere mantener las delicadas propiedades cuánticas coherentes durante el cálculo. Aquí es donde surge el principal obstáculo de la computación cuántica: la fragilidad de los cúbits frente al entorno. En las siguientes secciones exploraremos la evolución de los cúbits, por qué es tan difícil mantener sus estados cuánticos libres de errores y cómo un nuevo chip llamado Ocelot –basado en cúbits tipo “cat” (gato)– promete reducir drásticamente los errores cuánticos, acelerando el camino hacia computadoras cuánticas prácticas.

Historia y evolución de los cúbits

La idea de un computador cuántico comenzó a gestarse en la década de 1980, cuando científicos como Richard Feynman sugirieron que una máquina basada en fenómenos cuánticos podría simular sistemas físicos de forma mucho más eficiente que un ordenador clásico. Durante los años 1990 se dieron las primeras demostraciones experimentales de cúbits. En 1998, investigadores del Laboratorio Nacional de Los Álamos y el MIT lograron manipular un cúbit en una molécula mediante resonancia magnética nuclear, y ese mismo año se presentó en la Universidad de Berkeley la primera computadora cuántica de 2 cúbits. Un año después, en IBM Almaden se construyó una computadora cuántica de 3 cúbits que ejecutó por primera vez un algoritmo cuántico (la búsqueda de Grover). A inicios de los 2000, los avances se aceleraron: en 2001 IBM y la Universidad de Stanford implementaron el algoritmo de Shor en un computador cuántico de 7 cúbits (basado en moléculas orgánicas), logrando factorizar el número 15 = 3×5. Para 2005, grupos de investigación en Innsbruck habían conseguido 8 cúbits entrelazados en trampas de iones (lo que llamaron un “Qbyte“), y hacia finales de la década de 2000 empresas como D-Wave anunciaban dispositivos cuánticos especializados de mayor escala (aunque con enfoques distintos, como la adiabática cuántica).

Estos primeros cúbits podían ser de distintas naturalezas físicas: espines nucleares en moléculas (NMR), iones atrapados en campos electromagnéticos, fotones en circuitos ópticos o circuitos superconductores a bajas temperaturas, entre otros. Cada plataforma ofrecía distintas ventajas, pero todas compartían un problema común: a medida que se aumentaba el número de cúbits, se hacía cada vez más difícil aislarlos del ruido externo y controlar sus interacciones sin introducir errores. En la década de 2010, los cúbits superconductores (como los transmons) se volvieron prominentes gracias a esfuerzos de IBM, Google y otras compañías, logrando chips con decenas de cúbits. Por ejemplo, en 2019 Google anunció su chip Sycamore de 53 cúbits, demostrando la “supremacía cuántica” en una tarea específica. No obstante, dichos logros son frágiles: añadir más cúbits tiende a aumentar los errores a menos que se implementen métodos avanzados de corrección de errores.

Para abordar este reto, los científicos empezaron a crear el concepto de cúbits lógicos: combinaciones de varios cúbits físicos que funcionan como un solo cúbit más estable gracias a códigos de corrección de errores cuánticos (similar a usar bits de paridad o redundancia en computación clásica). En 1995, Peter Shor publicó el primer código cuántico de corrección de errores, marcando el inicio formal de este campo. Pocos años después, a finales de los 90, surgió una idea alternativa y prometedora: en lugar de usar muchos cúbits binarios frágiles, ¿por qué no codificar la información cuántica en estados más complejos de un solo sistema cuántico? Así nacieron los llamados cúbits “bosónicos”, que utilizan estados cuánticos de un oscilador (como un modo de luz microondas en una cavidad) para almacenar un cúbit de información. En 2001 se propuso por primera vez un tipo particular de cúbit bosónico conocido como “cat qubit” o cúbit gato. Su nombre alude al famoso experimento mental del gato de Schrödinger, ya que estos cúbits emplean la superposición de dos estados “clásicos” distinguibles (análogos a un gato vivo y muerto a la vez) para representar 0 y 1. Un cúbit cat se crea usando dos estados coherentes de un oscilador (como dos oscilaciones con fases diferentes). La combinación de estos estados representa el 0 cuántico y el 1 cuántico del cúbit.

Durante las dos décadas siguientes, investigadores de Yale, el Laboratorio Nacional de Los Álamos, Caltech y otros lugares exploraron y refinaron los cúbits tipo cat. Experimentos pioneros en la última década demostraron que un solo oscilador podía mantener un estado de superposición cuántica con cierta protección intrínseca contra errores. Sin embargo, hasta hace poco quedaba abierta la pregunta de si estos cúbits bosónicos podían escalarse e integrarse en una arquitectura completa de computación cuántica. Este 2025, un equipo de AWS en colaboración con Caltech ha dado un paso histórico en esa dirección: han construido Ocelot, el primer chip cuántico con arquitectura escalable basada en cúbits cat. Antes de detallar este avance, examinemos con más profundidad por qué los errores cuánticos son el talón de Aquiles de la computación cuántica y cómo los cúbits cat prometen aliviar este problema.

Línea de tiempo de la evolución de los cúbits

Década de 1980

Origen de la Idea: Richard Feynman plantea que una máquina basada en fenómenos cuánticos podría simular sistemas físicos de forma mucho más eficiente que un ordenador clásico.

Década de 1990

- Primeras Demostraciones Experimentales: Se realizan las primeras pruebas experimentales de cúbits en distintos laboratorios.

- 1998: Manipulación de un cúbit en una molécula mediante resonancia magnética nuclear y presentación de la primera computadora cuántica de 2 cúbits en Berkeley.

- 1999: IBM Almaden construye una computadora cuántica de 3 cúbits que ejecuta el algoritmo de búsqueda de Grover.

Años 2000

- 2001: IBM y la Universidad de Stanford implementan el algoritmo de Shor en un computador cuántico de 7 cúbits, demostrando la factorización del número 15 y se propone el “cat qubit”.

- 2005: Grupos en Innsbruck logran entrelazar 8 cúbits en trampas de iones (denominado “Qbyte”).

- Finales de la Década: Empresas como D-Wave anuncian dispositivos cuánticos especializados de mayor escala mediante la computación adiabática.

Década de 2010

- Cúbits Superconductores: Se destacan los cúbits superconductores (transmons) en proyectos de IBM, Google y otros, permitiendo chips con decenas de cúbits.

- 2019: Google presenta el chip Sycamore de 53 cúbits, demostrando la “supremacía cuántica”.

- Cúbits Lógicos: Avances en códigos de corrección de errores que permiten combinar múltiples cúbits físicos en cúbits lógicos.

Década de 2020

- Cúbits Bosónicos y Cat Qubits: Avances en la investigación de cúbits bosónicos y “cat qubits”, que protegen la superposición cuántica contra errores.

- 2025: Desarrollo del chip “Ocelot” por AWS y Caltech, el primer chip cuántico escalable basado en cúbits cat.

El problema de los errores cuánticos

Uno de los mayores retos para construir computadores cuánticos útiles es su extrema sensibilidad al ruido. Los cúbits, a diferencia de los robustos bits clásicos, pueden perder fácilmente su estado cuántico con la más mínima perturbación del entorno. Las vibraciones mecánicas, cambios de temperatura, interferencias de radios, celulares o redes Wi-Fi, y fuentes inevitables como los rayos cósmicos o la radiación natural de los materiales, pueden arruinar la superposición cuántica en un cúbit. Este fenómeno, conocido como decoherencia, esencialmente colapsa el cúbit a un valor erróneo de 0 ó 1, introduciendo errores en los cálculos cuánticos. En la práctica, los ordenadores cuánticos actuales cometen muchos más errores que las computadoras clásicas porque sus bits cuánticos “se olvidan” rápidamente de su estado.

Para visualizar el problema, imaginemos un cúbit representado por la orientación de una aguja magnética muy delicada. Mientras no reciba perturbaciones, la aguja puede apuntar simultáneamente en dos direcciones (superposición). Pero el más leve temblor de la mesa, o un soplo de viento, puede hacerla oscilar y terminar apuntando firmemente en una dirección u otra (perdiendo la superposición). Las perturbaciones cuánticas causan principalmente dos tipos de errores en un cúbit: errores de bit-flip (la analogía cuántica de que un 0 se convierta en 1, o viceversa) y errores de phase-flip (el estado cuántico adquiere un cambio de fase indetectable que altera las interferencias). En los bits clásicos solo preocupa el primer tipo (cambio de valor), pero en los cúbits existen ambos tipos, duplicando el desafío de mantener la fidelidad de la información.

En computación clásica, la corrección de errores se logra agregando bits redundantes y mecanismos de verificación. Por ejemplo, para proteger 1 bit de información se pueden usar tres copias y tomar una “votación” por mayoría si alguna copia difiere (votación 2 de 3). En cuántica no podemos simplemente copiar un cúbit debido al teorema de no-clonación, que prohíbe duplicar estados cuánticos arbitrarios. En su lugar, la estrategia es distribuir la información de un cúbit lógico en un conjunto entrelazado de varios cúbits físicos de tal manera que los errores puedan detectarse y corregirse antes de arruinar el cálculo. A esto se le llama corrección de errores cuánticos (QEC, por sus siglas en inglés).

El desafío con la QEC es que requiere un gran sobrecoste de recursos. Un código típico, como el código superficial que emplean Google e IBM, puede necesitar del orden de 50 a 100 cúbits físicos por cada cúbit lógico estable, e idealmente se proyecta que podrían requerirse miles para lograr tasas de error lo suficientemente bajas. De hecho, estimaciones sugieren que una computadora cuántica verdaderamente útil (capaz de, digamos, factorizar números muy grandes o simular moléculas complejas) podría requerir millones de cúbits físicos, dado que la mayoría estarían dedicados a la detección y corrección de errores. Esto está muy por encima de los pocos cientos de cúbits de los mayores chips cuánticos actuales. Oskar Painter, líder de hardware cuántico en AWS, ilustró la magnitud del problema: “Para que los computadores cuánticos tengan éxito, necesitamos que las tasas de error sean aproximadamente mil millones de veces mejores que las de hoy. Actualmente los errores bajan quizás a la mitad cada dos años; a ese ritmo tardaríamos 70 años en llegar adonde necesitamos”. Claramente, se requieren enfoques innovadores para acelerar la reducción de errores y lograr la llamada computación cuántica tolerante a fallos en plazos más razonables.

Las empresas y laboratorios punteros están explorando diversas estrategias para lidiar con los errores cuánticos. Google, por ejemplo, ha apostado por chips con cada vez más cúbits y la implementación de códigos de corrección como el código superficial: su reciente chip Willow integra un gran número de cúbits físicos formando varios cúbits lógicos más estables mediante entrelazamiento y corrección activa de errores. Microsoft, por otro lado, trabaja en qubits topológicos basados en quasipartículas de Majorana, un enfoque que aprovecha estados exóticos de la materia para hacer los cúbits intrínsecamente más robustos a las perturbaciones del entorno. Ambas vías –ya sea aumentando la cantidad de cúbits con códigos estándar, u optando por cúbits físicamente más resistentes– buscan el mismo fin: reducir las tasas de error para que los cálculos cuánticos sean fiables.

En este contexto aparece el chip Ocelot de AWS, que propone una tercera vía: diseñar desde cero una arquitectura de hardware donde la corrección de errores esté incorporada intrínsecamente en los cúbits mismos y en la disposición del chip. En la siguiente sección veremos en detalle cómo funciona Ocelot y sus cúbits tipo “cat”, y por qué representan un avance novedoso en la lucha contra los errores cuánticos.

Bases de datos de jurisprudencia en Colombia

El chip Ocelot y los cúbits tipo “cat”

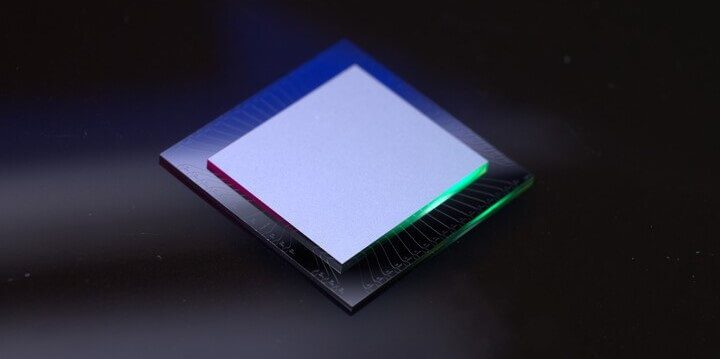

El nuevo chip Ocelot –presentado en 2025 por Amazon Web Services– es un prototipo de procesador cuántico construido con la corrección de errores como pieza central de su arquitectura. Su nombre (“ocelote” en inglés) es un guiño tanto al felino moteado como a la palabra “oscillator” (oscilador) en su interior, dado que utiliza cúbits basados en osciladores cuánticos tipo Schrödinger’s cat. En febrero de 2025, un equipo de AWS y Caltech reportó en la revista Nature la demostración exitosa de esta nueva arquitectura para suprimir errores cuánticos mediante cúbits cat. Se trata del primer chip escalable de cúbits cat integrado en tecnología superconductora, marcando un hito hacia computadores cuánticos tolerantes a fallos.

¿Qué es exactamente un cúbit tipo “cat”?

En Ocelot, los cúbits cat son circuitos superconductores resonantes (similares a diminutas cavidades de microondas) en los que se almacena un estado cuántico oscilatorio. A diferencia de un cúbit superconductor convencional (transmon), que esencialmente oscila entre dos niveles de energía, un cúbit cat utiliza muchos niveles del oscilador para formar dos estados cuánticos macroscópicamente distintos. Estos dos estados –analógos a las posibilidades “gato vivo” y “gato muerto” en el experimento de Schrödinger– están en superposición y sirven como los estados lógicos |0⟩ y |1⟩ del cúbit. La ventaja de esta codificación bosónica es que ciertos errores tienden a manifestarse como transiciones entre niveles que no mezclan esos dos estados colectivos. En términos prácticos, los cúbits cat suprimen intrínsecamente un tipo de error: los errores de bit-flip quedan exponencialmente suprimidos conforme se incrementa la energía (número de fotones) en el oscilador. Es decir, resulta extremadamente improbable que el cúbit salte espontáneamente del estado “gato” equivalente a |0⟩ al estado “gato” equivalente a |1⟩, lo que en un cúbit tradicional sería un error de bit. Esta protección interna es precisamente lo que hace especiales a los cúbits cat.

En contrapartida, los cúbits cat siguen siendo vulnerables a errores de fase (que alteran la relación de fase entre las componentes del estado superpuesto). Ocelot aborda este hecho combinando varios cúbits cat en una configuración que permite detectar y corregir esos errores de fase de manera eficiente. La arquitectura de Ocelot consiste en un arreglo lineal de 5 cúbits cat de datos (que almacenan la información cuántica), intercalados con cúbits auxiliares y circuitos especiales de estabilizació. En total, el chip contiene 14 componentes fundamentales: 5 cúbits cat que actúan como datos, 5 circuitos de amortiguamiento o buffer (uno acoplado a cada cúbit cat, encargados de estabilizar y mantener los estados de los cúbits cat), y 4 cúbits superconductores adicionales (tipo transmon) que funcionan como ancillas para detectar errores. Estos elementos se distribuyen en dos microchips de silicio de 1 cm² apilados y conectados entre sí, con capas delgadas de materiales superconductores (tantalio, entre otros) formando los circuitos cuánticos en su superficie. En pocas palabras, Ocelot implementa un cúbit lógico redundante empleando cúbits cat físicos: los errores de bit-flip casi nunca ocurren gracias a la naturaleza del cúbit cat, y los errores de fase se controlan mediante un sencillo código de repetición usando varias unidades cat.

¿Cómo corrige Ocelot los errores de fase?

Los 5 cúbits cat de datos están entrelazados a través de los cúbits ancilla de tal modo que forman un código de repetición de longitud 5. Si uno de los cúbits cat sufre un error de fase (un ligero cambio indetectable en su estado interno), las interacciones con los ancilla (mediante puertas lógicas CNOT especialmente ajustadas con sesgo de ruido) hacen que ese error señalice su presencia sin colapsar el estado de datos. En esencia, los cúbits ancilla actúan como sensores que “marcan” cuál cúbit cat pudo haber sufrido un error de fase, permitiendo luego corregirlo mediante operaciones cuánticas adicionales. Al mismo tiempo, los circuitos buffer conectados a cada cúbit cat aplican retroalimentación continua para estabilizar las oscilaciones y mantener las componentes del estado “gato” separadas, evitando que colapsen una en la otra. Esta combinación única de protección pasiva (dada por la física del cúbit cat) y corrección activa sencilla (gracias a unas pocas ancillas y un código de repetición) resulta ser muy eficiente en términos de recursos.

Los resultados experimentales publicados muestran cifras impresionantes. Gracias a la supresión exponencial de errores de bit-flip, los cúbits cat de Ocelot lograron tiempos medios antes de un error de bit (coherencia de bit-flip) del orden de 1 segundo. Para ponerlo en perspectiva, 1 segundo es más de mil veces mayor que la vida media típica de un cúbit superconductor convencional antes de un error de bit. Esto significa que, efectivamente, los errores de bit en Ocelot ocurren miles de veces menos frecuentemente. Por otro lado, los tiempos de coherencia de fase obtenidos fueron del orden de decenas de microsegundos, lo cual es suficiente para aplicar cientos de operaciones de corrección antes de que un error de fase no detectado arruine el cálculo. Al ejecutar ciclos periódicos de detección y corrección de errores en el arreglo de cúbits cat (simulando la memoria de un cúbit lógico), el equipo demostró que al aumentar de un código de repetición de distancia 3 a uno de distancia 5 (es decir, de usar 3 cúbits cat a usar los 5) la tasa de error de fase del cúbit lógico disminuye significativamente. En otras palabras, agregar más cúbits cat de redundancia mejoró la fidelidad, evidenciando que la arquitectura es escalable: en principio, usar códigos de repetición más largos (más cúbits cat) seguirá reduciendo la tasa de errores lógicos.

Un punto crucial es que toda esta corrección de errores se logró con muchos menos recursos que las aproximaciones tradicionales. Según AWS, Ocelot logra reducir los recursos necesarios para la corrección cuántica de errores en hasta un 90% respecto a los enfoques convencionales. Dicho de otra forma, “es posible que una computadora cuántica construida siguiendo la arquitectura Ocelot requiera tan solo una décima parte de los cúbits que necesitaría un enfoque estándar para lograr el mismo rendimiento”, afirmaron Oskar Painter y sus colegas. Esta enorme ganancia en eficiencia se debe a que cada cúbit cat ya aporta una forma de redundancia interna (fotones en el oscilador) que disminuye la necesidad de cúbits extra dedicados a corrección. En lugar de tener que agrupar, por ejemplo, 100 cúbits físicos para combatir todos los errores de uno lógico, con los cúbits cat quizás basten unas pocas unidades adicionales. Como resultado, el chip Ocelot consigue un cúbit lógico fault-tolerant (tolerante a fallos) con solo 5 cúbits cat + ancillas, cuando vía código superficial podrían haberse requerido decenas de cúbits físicos.

Cabe destacar que Ocelot es aún un prototipo en etapa experimental. Por ahora es esencialmente un chip de memoria cuántica que almacena un cúbit lógico durante un tiempo limitado, pero no realiza operaciones aritméticas universales entre múltiples cúbits lógicos. No obstante, representa un avance fundamental: demuestra en hardware real que los cúbits bosónicos tipo cat pueden integrarse y operar conjuntamente para corrección de errores, allanando el camino para arquitecturas más grandes. AWS planea continuar mejorando el diseño y escalándolo a más cúbits y circuitos por chip. Aun quedan desafíos significativos, como reducir los errores de las propias puertas lógicas y ancillas, y mantener la ventaja de sesgo de ruido a mayor escala. Con todo, Ocelot marca un nuevo rumbo en la carrera hacia computadoras cuánticas útiles, ofreciendo una tercera vía prometedora distinta a la de “muchos cúbits físicos” (Google, IBM) y a la de “cúbits físicamente ideales” (Microsoft).

Comparaciones con otras estrategias de corrección de errores

Es ilustrativo comparar la estrategia de Ocelot con otras aproximaciones en desarrollo para lograr qubits estables:

- Códigos cuánticos tradicionales (superficiales o LDPC): La mayoría de los laboratorios (Google, IBM, universidades) trabajan en códigos de corrección que distribuyen la información de un cúbit lógico en una rejilla de cúbits físicos. Por ejemplo, el código superficial organiza cúbits en una red bidimensional donde medidas frecuentes detectan patrones de error que pueden corregirse. Esta técnica es muy genérica –puede corregir cualquier tipo de error– pero requiere muchos cúbits y compuertas. Google recientemente presentó su chip Willow con 70 cúbits, intentando construir un cúbit lógico de alta fidelidad combinando decenas de físicos. El costo de esta solución es que quizás se necesiten miles de cúbits físicos para lograr un computador cuántico de decenas de cúbits lógicos sin errores. A corto plazo, esto implica fabricar chips mucho más grandes y complejos que los actuales, lo cual es un reto de ingeniería considerable.

- Qubits topológicos (Majorana): Microsoft encabeza un enfoque diferente, buscando realizar cúbits cuya propia naturaleza física los haga menos propensos a errores. Se basan en estados topológicos de la materia, donde la información cuántica queda “protegida” en modos no locales (como los fermiones de Majorana). La teoría predice que tales cúbits serían inherentemente inmunes a ciertas perturbaciones locales, reduciendo drásticamente la necesidad de corrección activa. En 2023, investigadores de Microsoft reportaron evidencia de modos de Majorana y anunciaron un chip experimental basado en este principio, alegando que podría acelerar la llegada de una computadora cuántica útil de décadas a solo unos años. Si bien es prometedor, este enfoque aún se encuentra verificando los fundamentos físicos; lograr qubits topológicos estables y controlables es complejo, y todavía no se ha demostrado un cúbit lógico topológico completo.

- Cúbits bosónicos (códigos de oscilador): Aquí es donde se sitúa Ocelot. En vez de usar muchos elementos de dos niveles, se usa un solo elemento con muchos niveles (un oscilador con múltiples fotones) para codificar el cúbit de manera redundante. Dentro de este grupo están los códigos de gato (cat) y también otros como el código GKP (propuesto por Gottesman, Kitaev y Preskill en 2001) que codifica los estados 0/1 en estados “peine” de un oscilador armónico. Todos estos buscan aprovechar grados de libertad adicionales de un sistema cuántico continuo para facilitar la detección de errores. La ventaja es la eficiencia en hardware: se aumenta la cantidad de información cuántica útil por cada dispositivo físico. Antes de Ocelot, se habían demostrado cúbits bosónicos individuales con corrección autónoma de ciertos errores, pero no una integración de varios en un circuito mayor. Ocelot justamente muestra que es posible combinar múltiples cúbits bosónicos en un chip y ejecutar rutinas de corrección entre ellos, manteniendo la promesa teórica de necesitar menos recursos.

- Otras técnicas híbridas: También existen enfoques intermedios, como la corrección de errores asistida por hardware donde elementos físicos (p.ej., modos disipativos o filtros) eliminan selectivamente ciertos errores, o la mitigación de errores a nivel de software (posprocesado de resultados para corregir sesgos de error sin overhead de cúbits). Estas estrategias a veces se usan temporalmente en computadores cuánticos ruidosos actuales, pero no garantizan escalabilidad a largo plazo como lo hace un verdadero cúbit con corrección integrada.

En comparación con lo anterior, la propuesta de Ocelot destaca por combinar dos capas: un cúbit físicamente sesgado hacia pocos errores (bosónico) y un código sencillo de pocos cúbits para los errores restantes. Esto la vuelve extremadamente eficiente. De acuerdo a AWS, su enfoque podría requerir solo una décima parte de los recursos respecto a códigos tradicionales para alcanzar computación tolerante a fallos. Otra forma de expresarlo la dio Oskar Painter con una analogía de fabricación: es como si Ocelot lograra la misma calidad final con 1 punto de control de calidad en vez de 10, gracias a que cada componente sale ya más afinado de fábrica. En lugar de construir un chip cuántico cualquiera y después intentar corregirle los errores con muchos parches, Ocelot diseña el chip desde el inicio pensando en minimizar los errores.

Por supuesto, cada estrategia tiene sus retos. Los códigos tradicionales necesitan chips muy grandes pero se basan en física bien conocida. Los qubits topológicos requieren nuevos descubrimientos en física de materiales, aunque prometen saltarse mucho overhead. Ocelot, con cúbits cat, ha probado su eficacia a pequeña escala, pero deberá mostrar que puede extenderse a procesadores más complejos (con muchos cúbits lógicos interactuando) sin perder su ventaja. Podría incluso combinarse enfoques en el futuro: por ejemplo, usar cúbits cat dentro de códigos superficiales para reducir aún más los recursos, o emplear qubits topológicos junto con bosónicos. En el panorama actual, Ocelot representa una dirección fresca y muy esperanzadora, complementando los esfuerzos de Google, IBM y otros, y acercándonos más rápidamente a la meta de computación cuántica práctica.

Impacto y futuro de la computación cuántica

La demostración del chip Ocelot con cúbits cat es un avance significativo hacia computadores cuánticos útiles en el mundo real. Si esta arquitectura logra escalar exitosamente, aceleraría la llegada de la computación cuántica plenamente funcional. Los investigadores de AWS estiman que podría adelantar en hasta 5 años la realización de un computador cuántico práctico en comparación con los tiempos esperados usando tecnologías previas. Asimismo, proyectan que los futuros chips cuánticos basados en Ocelot podrían costar tan solo una quinta parte de las aproximaciones actuales, debido a la reducción drástica de cúbits y hardware extra dedicados a la corrección de errores. En otras palabras, la computación cuántica podría volverse más asequible y escalable gracias a este tipo de innovaciones, lo cual animaría una competencia aún mayor en el campo.

¿Cuáles serían las consecuencias de lograr computadoras cuánticas tolerantes a fallos con decenas o cientos de cúbits lógicos?

Las implicaciones abarcan numerosos campos:

- Criptografía y ciberseguridad: Un computador cuántico potente podría romper esquemas de cifrado ampliamente usados, como RSA y ECC, en tiempos relativamente cortos gracias a algoritmos cuánticos de factorización y logaritmos discretos (Shor). Esto representa un reto enorme para la seguridad digital, obligando a desarrollar e implantar nuevos algoritmos post-cuánticos resistentes a ataques cuánticos. Al mismo tiempo, la computación cuántica habilitará nuevas formas de comunicación segura, como la distribución cuántica de claves (QKD), cuyo despliegue podría acelerarse. Tener máquinas cuánticas fiables también permitiría investigar protocolos criptográficos cuánticos más sofisticados y verificar su seguridad en la práctica.

- Medicina y descubrimiento de fármacos: La simulación cuántica de moléculas complejas y reacciones químicas es una de las aplicaciones más esperadas. Computadoras cuánticas sin errores podrían modelar con precisión la interacción entre proteínas y medicamentos, o el comportamiento de enzimas, tareas que hoy requieren aproximaciones y simplificaciones en supercomputadoras clásicas. Esto agilizaría el diseño de nuevos fármacos y tratamientos, reduciendo costos de I+D en la industria farmacéutica. Por ejemplo, podrían explorarse en días compuestos químicos y sus efectos que clásicamente tomarían años de simulación o experimentación. Asimismo, en biología cuántica se podrían entender mejor procesos como la fotosíntesis o la olfacción a nivel molecular.

- Ciencia de materiales y química cuántica: De manera similar, los computadores cuánticos facilitarán el diseño de materiales avanzados, como superconductores de alta temperatura, nuevos imanes moleculares, materiales ligeros y ultra resistentes, o compuestos para baterías de próxima generación. La capacidad de simular las interacciones electrónicas en sólidos y moléculas sin las simplificaciones de la química cuántica clásica permitiría descubrir fenómenos y propiedades emergentes, guiando la creación de materiales con características a la carta. Esto podría impactar industrias desde la energía (paneles solares más eficientes, catalizadores para producción de hidrógeno) hasta la electrónica (nuevos semiconductores o qubits más robustos).

- Optimización, finanzas e IA: Muchas problemáticas en negocios y ciencia se reducen a optimizar combinaciones entre un número enorme de posibilidades (rutas de logística, asignación de recursos, portafolios financieros, etc.). Los algoritmos cuánticos de optimización y quantum annealing podrían hallar soluciones óptimas o casi óptimas mucho más rápido que los algoritmos tradicionales, especialmente en problemas de gran escala. En finanzas, por ejemplo, se podrían hacer predicciones de riesgo e inversiones más precisas analizando simultáneamente inmensas cantidades de escenarios. En inteligencia artificial, los métodos cuánticos podrían acelerar el entrenamiento de modelos de machine learning o permitir modelos probabilísticos más complejos que mejoren la toma de decisiones.

- Ciencia básica y otras áreas: Un computador cuántico universal tolerante a fallos sería una herramienta revolucionaria para la física teórica y experimental. Podría simular sistemas cuánticos de muchos cuerpos (p.ej., superconductividad no convencional, plasma nuclear, cosmología cuántica) que son intratables numéricamente. También permitiría resolver problemas matemáticos y de computación hoy fuera de alcance, e incluso explorar nuevos algoritmos aún no imaginados. Campos emergentes como la metrología cuántica (sensores ultra precisos) e internet cuántica se beneficiarían de control cuántico más robusto. En resumen, habilitaría una nueva era de descubrimientos científicos gracias a una capacidad computacional sin precedentes.

Por supuesto, alcanzar ese futuro no ocurrirá de la noche a la mañana. Tras Ocelot, se requerirán múltiples generaciones de chips cuánticos cada vez más complejos. Como señaló O. Painter, “apenas estamos comenzando y aún tenemos varias etapas de escalado por atravesar”. Es un camino de investigación y desarrollo prolongado, donde cada incremento en número de cúbits y reducción de errores presentará nuevos desafíos. Será necesario continuar innovando en todos los niveles de la pila cuántica: desde nuevos materiales superconductores más coherentes, mejores diseños de circuitos (quizá incorporando también ideas topológicas), hasta algoritmos y software optimizados para estas arquitecturas híbridas. La competencia entre iniciativas académicas, corporativas (AWS, IBM, Google, Microsoft, Intel, etc.) y startups cuánticas probablemente se intensificará, lo cual es bueno ya que fomentará avances rápidos.

En conclusión, el chip Ocelot demuestra una forma ingeniosa de combatir los errores cuánticos aprovechando la física de los cúbits cat. Su éxito sugiere que computadores cuánticos más útiles podrían llegar antes de lo esperado, posiblemente en esta misma década, si se logra escalar este enfoque. Esto podría traducirse en enormes beneficios en criptografía, medicina, ciencia de materiales y muchos otros campos donde la computación clásica encuentra límites. Aunque queda mucho trabajo por hacer, innovaciones como Ocelot nos acercan un paso más a convertir la ciencia ficción de la computación cuántica en una realidad cotidiana. El futuro cuántico luce cada vez más brillante y cercano, gracias a desarrollos técnicos sólidamente apoyados en principios físicos, pero comunicados en un lenguaje que incluso un “gato de Schrödinger” aprobaría.

Referencias y fuentes académicas

- AWS & Caltech (2025). Nuevo chip Ocelot con cúbits cat para reducción de errores. Publicado en Nature, 26 de febrero de 2025 caltech.edu.

- Equipo AWS Quantum Hardware (2025). Amazon Science Blog – Amazon anuncia el chip cuántico Ocelot basado en cúbits cat. Disponible en Amazon.Scienceamazon.science.

- Equipo About Amazon (2025). Comunicado oficial – AWS presenta su nuevo chip de computación cuántica Ocelot (27/02/2025) aboutamazon.es.

- Hernández, G. (2025). Xataka – El chip cuántico Ocelot de Amazon se basa en el gato de Schrödinger para equivocarse menos xataka.com.mx.

- Microsoft Azure Quantum (2022). ¿Qué es la computación cuántica? – Introducción a superposición y entrelazamiento learn.microsoft.com.

Bases de datos de jurisprudencia en Colombia

La investigación de jurisprudencia en Colombia puede realizarse a través de diversas bases de datos,…

Algoritmos IA para mejorar el mundo: El enfoque de Manish Raghavan para abordar problemas sociales a través de la computación.

La inteligencia artificial (IA) y el uso de algoritmos computacionales han transformado de manera acelerada…

OpenAI lanza ChatGPT Gov para el gobierno de los Estados Unidos

OpenAI lanza ChatGPT Gov para el gobierno de los Estados Unidos El 28 de enero…

Ventajas y desventajas de la globalización: Un Fenómeno Controvertido

Las ventajas y desventajas de la globalización definen ese término omnipresente en nuestras conversaciones económicas…