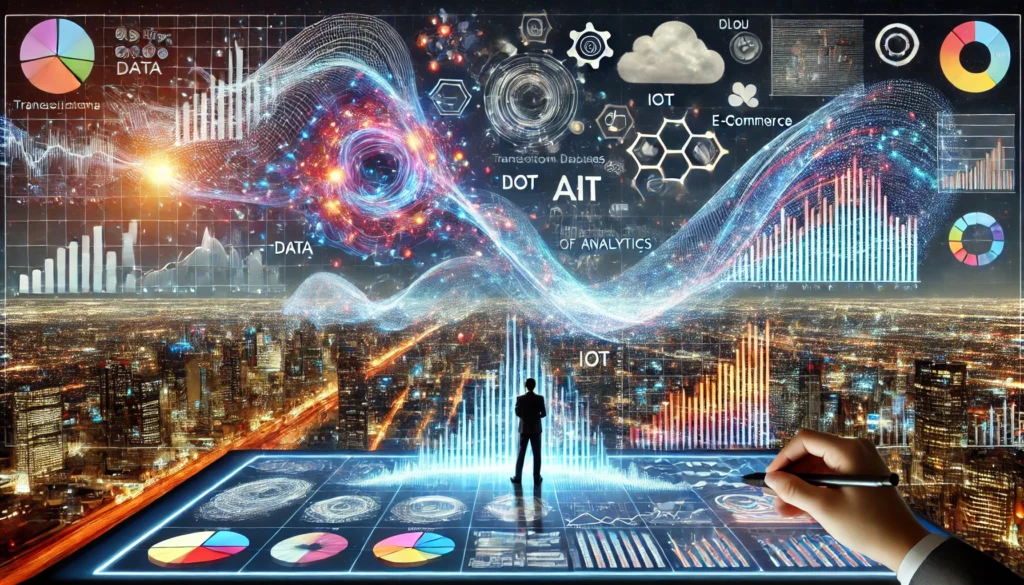

En la era digital, la cantidad de datos que se generan a diario crece a un ritmo exponencial. Las organizaciones recogen información de múltiples fuentes: bases de datos transaccionales, sensores y dispositivos (IoT), redes sociales, aplicaciones de comercio electrónico, telemetría de servicios en la nube y mucho más. En consecuencia, convertir este océano de datos en información procesable y relevante se ha convertido en un factor diferenciador para la competitividad empresarial.

En el caso de una empresa minorista, por ejemplo, la recolección y almacenamiento de datos sobre productos comprados, artículos consultados, páginas visitadas, pasillos recorridos y hábitos de gasto de los clientes generan un volumen masivo de información. Sin embargo, el verdadero reto radica en transformar estos datos en algo que verdaderamente influya en la operación de la empresa: optimizar inventarios, detectar fraudes, personalizar recomendaciones, entender tendencias de compra, etc.

La idea de “contar historias” con datos (data storytelling) surge de la necesidad de comunicar y explicar de manera clara lo que los números, gráficas y estadísticas tienen para decir. Solo cuando un responsable de la toma de decisiones ve esos datos convertidos en insights (conclusiones valiosas) puede actuar y dirigir estrategias que generen valor real.

El presente artículo expone los conceptos fundamentales del análisis de datos, las técnicas analíticas más relevantes (descriptiva, diagnóstica, predictiva, prescriptiva, cognitiva), los roles involucrados en el ciclo de vida de los datos (analista de datos, ingeniero de datos, científico de datos, entre otros) y, finalmente, las tareas principales de un analista de datos para lograr un análisis eficiente. Se pretende, así, promover una cultura de datos en las organizaciones que facilite la narración y comunicación de historias significativas y oportunas.

- El rol estratégico de los datos en las organizaciones

- Del dato a la historia: la esencia del análisis de datos

- Roles clave en el ecosistema de datos

- Las tareas del analista de datos

- Creando una cultura de datos en la organización

- Casos de uso ilustrativos

- Recomendaciones para un análisis de datos eficaz

- Herramientas y tecnologías emergentes

- Desafíos y tendencias futuras en el análisis de datos

- Conclusiones

- Fuentes y lecturas recomendadas

El rol estratégico de los datos en las organizaciones

Para muchas empresas, los datos representan hoy en día el activo más importante de su organización. Con los datos, se pueden descubrir patrones, tendencias y oportunidades de negocio. En un entorno tan competitivo, no basta únicamente con recopilar información; es fundamental extraer valor de ella a tiempo. Aquel negocio que es capaz de:

- Interpretar de forma confiable lo que sucede en el mercado.

- Anticiparse a las tendencias futuras.

- Optimizar sus procesos internos basándose en datos.

… se posicionará un paso adelante de sus competidores.

Algunos ejemplos claros que ilustran la manera en que los datos transforman el quehacer empresarial, sobre todo en las organizaciones minoristas (retail), son:

- Seguimiento de inventario: mediante la monitorización en tiempo real de las existencias para evitar quiebres de stock (o sobrestock) y reducir costes.

- Identificación de hábitos de compra: detectar la frecuencia y los canales de compra para diseñar promociones personalizadas o mejorar la experiencia de usuario.

- Detección de tendencias y patrones: entender qué productos se venden más en ciertas temporadas o qué zonas geográficas presentan demanda creciente.

- Recomendación de compras: ofrecer productos basados en las preferencias y el historial de consumo de un cliente (sistemas de recomendación).

- Optimización de precios: ajustar dinámicamente los precios según demanda, competencia y márgenes objetivo.

- Detección de fraude: descubrir comportamientos atípicos que puedan indicar robos o uso fraudulento de tarjetas, cupones y otros métodos de pago.

Un punto clave es que este proceso de descubrimiento de oportunidades e insights no se limite a la simple extracción de datos: lo fundamental es contar una historia y actuar en función de ella. Los líderes empresariales requieren informes y narrativas que expliquen y sinteticen los hallazgos. No basta con presentar un panel complejo: la visualización y la creación de un relato coherente le dan sentido a la información. Allí reside el auténtico valor del análisis de datos.

Del dato a la historia: la esencia del análisis de datos

El análisis de datos se encarga de transformar datos crudos y dispersos en información coherente. El objetivo final de un proceso analítico no es solo una base de datos limpia, sino la obtención de conclusiones y recomendaciones estratégicas para la empresa. Este proceso —donde se identifican, limpian, transforman y modelan los datos— busca responder preguntas críticas de la organización y facilitar la toma de decisiones.

Categorías de análisis de datos

Si bien existen diversas clasificaciones, en el entorno empresarial es común agrupar el análisis de datos en cinco grandes categorías:

- Análisis descriptivo

Responde a la pregunta: “¿Qué ha sucedido?”.

Se basa en datos históricos y ayuda a entender patrones y comportamientos pasados. Suele utilizarse para elaborar informes de KPI (indicadores clave de rendimiento), tablas, gráficos y resúmenes estadísticos. Por ejemplo, un minorista que observa las ventas de cada mes para comprender qué productos fueron más populares en un trimestre específico. - Análisis de diagnóstico

Responde a la pregunta: “¿Por qué ha sucedido?”.

Amplía el análisis descriptivo al investigar las causas y razones que explican un fenómeno. Implica identificar anomalías en los datos y usar técnicas estadísticas para establecer relaciones y correlaciones. Un ejemplo sería descubrir por qué las ventas bajaron en cierta región, si influyeron factores externos o cambios de precios. - Análisis predictivo

Responde a la pregunta: “¿Qué sucederá?”.

Utiliza datos históricos para predecir tendencias futuras. Emplea algoritmos de machine learning, regresiones, árboles de decisión o redes neuronales para estimar eventos y comportamientos probables. Un caso práctico: proyectar la demanda de un producto en Navidad y así planificar mejor el inventario. - Análisis prescriptivo

Responde a la pregunta: “¿Qué debería hacerse?”.

Va más allá de la predicción para sugerir acciones concretas. Se basa en técnicas de optimización y simulación para determinar cuál es la mejor decisión bajo diferentes escenarios e incertidumbres. Por ejemplo, recomendar cómo asignar presupuestos de marketing según las respuestas esperadas en cada canal. - Análisis cognitivo

Busca inferir conclusiones a partir de datos y patrones existentes, derivar nuevos conocimientos y retroalimentar ese aprendizaje. Emplea algoritmos de aprendizaje profundo y técnicas de procesamiento de lenguaje natural. Un ejemplo sería un sistema cognitivo que “aprenda” continuamente de reseñas de productos y adapte las conclusiones en tiempo real.

Confiar en los datos

Para que el análisis sea válido, los datos deben provenir de fuentes confiables y estar debidamente limpiados y transformados. La calidad de la información es esencial. De lo contrario, las conclusiones podrían llevar a decisiones erróneas. La limpieza y normalización de datos suelen ser la parte más laboriosa y tediosa en cualquier proyecto de análisis. Sin embargo, es una inversión necesaria para que el resultado final sea de confianza.

Roles clave en el ecosistema de datos

El proceso de gestión y análisis de datos es complejo y, por lo general, requiere la participación de varios perfiles especializados. Tradicionalmente, se hablaba de analistas de negocio y responsables de inteligencia de negocios (BI), pero con el aumento del volumen y la diversidad de los datos, surgieron roles más especializados:

- Analista de negocios

Se enfoca en interpretar los datos y comprender cómo estos afectan la estrategia de la empresa. Conoce a fondo el negocio y puede “traducir” las necesidades en requisitos analíticos. A veces, las tareas de un analista de negocios y de un analista de datos pueden solaparse. - Analista de datos

Es el profesional que explota las herramientas de visualización (p. ej., Microsoft Power BI, Tableau, Qlik) para diseñar informes y modelos de datos. Se encarga de limpiar, modelar y transformar los datos, construyendo modelos semánticos que luego sirven para que otros usuarios exploren la información. Trabaja de la mano con ingenieros de datos y con científicos de datos para extraer insights. - Ingeniero de datos

Aprovisiona y configura las plataformas de datos, tanto en la nube como en entornos on-premise. Su responsabilidad recae en administrar y proteger el flujo de datos (estructurados o no estructurados) procedentes de múltiples orígenes. Configura bases de datos relacionales, NoSQL, lagos de datos, canalizaciones (pipelines) de ingesta y procesos de transformación (ETL/ELT). Garantiza además que los servicios se integren de manera segura. - Científico de datos

Realiza análisis avanzados, que van desde lo descriptivo hasta lo predictivo (y a veces cognitivo). Emplea machine learning, deep learning y estadística para descubrir patrones complejos y generar modelos predictivos. A menudo formula hipótesis y diseña experimentos para validarlas. El científico de datos colabora con analistas de datos para visualizar y comunicar los hallazgos. - Administrador de base de datos (DBA)

Es responsable de la implementación y gestión de las bases de datos a nivel operativo. Supervisa el rendimiento, asegura la disponibilidad y diseña los planes de seguridad, respaldo y recuperación ante desastres. Aunque en algunos aspectos pueda parecer similar al ingeniero de datos, el DBA está más centrado en la administración de los entornos de base de datos que en la ingeniería y modelado de los flujos de datos.

Cada rol tiene áreas de superposición con los otros. En organizaciones más pequeñas, una sola persona puede desempeñar más de un rol. En estructuras más grandes, estos roles suelen estar bien diferenciados para cubrir todo el ciclo de vida del dato.

Las tareas del analista de datos

Dentro de este ecosistema, el analista de datos juega un papel de enlace entre la parte técnica y la parte estratégica de la organización. A continuación, se describen las cinco tareas principales en las que suele participar:

- Preparación de datos

- Generación de perfiles: entender la estructura, tipos de datos, valores perdidos, duplicados y estadísticas descriptivas.

- Limpieza y transformación: corregir datos incompletos o con errores, unificar formatos, normalizar, anonimizar información sensible.

- Conexión a orígenes: decidir el método de acceso (importación, conexión directa, etc.) y atender consideraciones de rendimiento.

- Seguridad y privacidad: aplicar controles de acceso, enmascaramiento o supresión de datos conforme a normativas (p. ej., GDPR).

- Modelado

- Definición de relaciones entre las tablas o conjuntos de datos.

- Creación de métricas y KPIs que faciliten el análisis.

- Uso de lenguajes de modelado y fórmulas (DAX en Power BI, por ejemplo) para enriquecer la capa semántica.

- Optimización del rendimiento de los modelos a gran escala.

- Visualización

- Diseño de informes y paneles (dashboards) que cuenten una historia visualmente.

- Selección de objetos visuales adecuados (gráficas de barras, líneas, mapas, etc.) para cada indicador.

- Uso de colores y fuentes accesibles.

- Incorporación de IA integrada (por ejemplo, objetos visuales de Power BI basados en aprendizaje automático).

- Análisis

- Empleo de funciones analíticas para buscar conclusiones en los datos: detectar patrones, correlaciones, tendencias, valores atípicos.

- Formulación de hipótesis y validación a través de datos.

- Integraciones de IA: análisis predictivo, análisis de sentimientos, segmentación de clientes, etc.

- Comunicación de resultados de forma clara y concisa para facilitar la toma de decisiones.

- Administración

- Gestión de los recursos de Power BI (o la herramienta utilizada): informes, paneles, áreas de trabajo, modelos.

- Configuración de permisos y roles para garantizar la seguridad de la información.

- Publicación y distribución de contenidos: creación de aplicaciones, actualización de datasets, configuración de gateways, etc.

- Colaboración con otros departamentos para reducir silos de datos y duplicaciones.

Creando una cultura de datos en la organización

Para que el análisis de datos sea realmente efectivo, debe integrarse en la cultura y la estrategia organizacional. Una cultura de datos implica:

- Apoyo de la alta dirección: los líderes de la empresa deben promover el uso de datos para la toma de decisiones, respaldando iniciativas de formación y asignando recursos a la infraestructura de datos.

- Democratización de la información: los datos deben ser accesibles (siempre con los debidos controles de seguridad) para el personal que los necesite.

- Herramientas sencillas de usar: el personal operativo y los directivos no tienen por qué ser expertos en codificación o estadística para obtener insights. Herramientas de self-service BI facilitan este proceso.

- Formación continua: la alfabetización de datos (data literacy) es fundamental para que los usuarios entiendan cómo interpretar las visualizaciones, cuestionar las fuentes y tomar decisiones más acertadas.

Contar historias con datos o data storytelling también forma parte de esta cultura. El analista de datos, o quien comunique los resultados, debe asumir el rol de “narrador” capaz de guiar al público a través de la información, resaltando los puntos críticos y concluyendo con recomendaciones claras.

Casos de uso ilustrativos

A continuación, presentamos algunos ejemplos donde el análisis de datos y la narración de insights juegan un papel crucial:

- Minorista de productos electrónicos

- Problema: altos índices de devolución de un modelo de teléfono celular.

- Solución: a través de un análisis descriptivo, el analista descubre que la mayoría de devoluciones proviene de ciertas tiendas específicas. Con análisis de diagnóstico, se averigua que en dichas tiendas se ofrecía una oferta promocional con condiciones poco claras, lo que generaba confusión y devoluciones.

- Historia: la narrativa se centra en cómo la falta de información precisa en el punto de venta llevó a tasas de devolución anormales y se propusieron mejoras en la comunicación al cliente.

- Empresa de servicios financieros

- Problema: alto porcentaje de usuarios que abandonan el proceso de solicitud de crédito en línea.

- Solución: el analista de datos instrumenta el sitio web para recopilar datos de navegación. Encuentra que muchos clientes se detienen en el paso de subir documentos. Usando análisis predictivo, se pronostica que el envío de recordatorios personalizados vía email reduciría la tasa de abandono en un 30%.

- Historia: con un panel de control y una narrativa bien estructurada, se explica que la fricción en la experiencia de usuario afecta la conversión y propone acciones (simples recordatorios) para recuperarlos.

- Sector industrial

- Problema: paradas inesperadas en la línea de producción que generan pérdidas millonarias.

- Solución: un modelo predictivo basado en la telemetría de las máquinas identifica patrones de fallas inminentes y sugiere mantenimientos proactivos.

- Historia: se muestra la correlación entre horas de uso, vibración de máquinas, fluctuaciones de temperatura, etc. y la probabilidad de falla. El resultado es un plan de mantenimiento inteligente que reduce costes.

Cada una de estas situaciones muestra cómo la data se convierte en una historia que impulsa decisiones concretas y valiosas.

Recomendaciones para un análisis de datos eficaz

Para lograr un análisis de datos sólido y confiable que culmine en historias valiosas para la toma de decisiones, se pueden seguir las siguientes recomendaciones:

- Definir claramente los objetivos

Antes de empezar, es crucial saber qué problema se intenta resolver y qué preguntas se buscan responder. Esto evita recopilar datos innecesarios y perder foco. - Asegurar la calidad de los datos

Un proceso bien definido de limpieza, validación y transformación de datos reduce el riesgo de conclusiones erróneas.Cita común: “Garbage in, garbage out” (si los datos de entrada son de mala calidad, las conclusiones también lo serán). - Seleccionar las herramientas adecuadas

- Para procesamiento en la nube: Azure Data Factory, Azure Synapse, etc.

- Para visualización y BI: Microsoft Power BI, Tableau, Qlik Sense.

- Para análisis avanzado y modelado: Python (con librerías como pandas, scikit-learn), R, o incluso AutoML.

- Involucrar a las partes interesadas

Es vital el feedback de los equipos de negocio. Son ellos quienes conocen el contexto y pueden validar la relevancia de los insights. - Fomentar la colaboración entre roles

Analistas, ingenieros, científicos de datos y administradores de base de datos deben trabajar conjuntamente, cada uno aprovechando su experiencia para acelerar el ciclo de descubrimiento y entrega de valor. - Iterar y mejorar continuamente

El ciclo de análisis (preparación, modelado, visualización, análisis y administración) es iterativo. Se refinan los modelos, se adaptan nuevos datos, se optimiza el rendimiento y se incorporan nuevas preguntas de negocio. - Comunicar los resultados con claridad

Más allá de las visualizaciones, es fundamental contar con un relato:- Explicar el contexto,

- Justificar la metodología,

- Presentar evidencias,

- Concluir con hallazgos y, finalmente,

- Proponer acciones o decisiones recomendadas.

Herramientas y tecnologías emergentes

El campo del análisis de datos está en constante evolución. Algunas tecnologías y enfoques que están ganando relevancia:

- Inteligencia artificial explicable (XAI): busca que los modelos de machine learning sean interpretables y transparentes, especialmente en sectores regulados como la banca y la medicina.

- Realidad aumentada y visual analytics: integración de capacidades de análisis con interfaces inmersivas, facilitando la exploración de datos en 3D o entornos virtuales.

- DataOps: conjunto de prácticas de ingeniería y automatización orientadas a optimizar el desarrollo y la entrega de productos de datos.

- Procesamiento de lenguaje natural (NLP): ampliando la capacidad de analizar datos no estructurados como comentarios en redes sociales, reseñas de productos o transcripciones de llamadas.

- AutoML (Automated Machine Learning): permite que usuarios con menos conocimientos técnicos construyan modelos predictivos con un alto grado de automatización en la selección y optimización de algoritmos.

Estas herramientas refuerzan la tendencia de democratizar el acceso a la analítica y reducir la brecha entre los expertos técnicos y los usuarios de negocio.

Desafíos y tendencias futuras en el análisis de datos

Pese a los grandes avances, existen todavía desafíos que las organizaciones deben enfrentar:

- Gobernanza de datos: mantener un equilibrio entre accesibilidad y seguridad, cumplir con normativas (como GDPR, CCPA) y garantizar la calidad continua.

- Sesgo algorítmico: los modelos pueden reproducir o amplificar sesgos existentes en los datos, afectando decisiones críticas (por ejemplo, aprobación de créditos).

- Escalabilidad y rendimiento: el volumen de datos sigue creciendo. Las arquitecturas deben ser capaces de escalar eficientemente y evitar cuellos de botella.

- Escasez de talento: la demanda de profesionales en data science, data engineering y data analytics supera la oferta.

- Necesidad de formación continua: las herramientas y técnicas cambian rápidamente, por lo que los equipos deben mantenerse siempre actualizados.

En el futuro, se espera ver un mayor uso de la IA y el aprendizaje profundo en entornos de edge computing y soluciones híbridas, donde partes del procesamiento y análisis de datos pueden ocurrir localmente (por ejemplo, en dispositivos IoT) y otra parte en la nube. Además, la automatización de procesos repetitivos permitirá a los analistas enfocarse más en la parte creativa y estratégica del análisis.

Conclusiones

El análisis de datos moderno ha dejado de ser un mero proceso técnico para convertirse en un factor estratégico para organizaciones de todos los tamaños. La habilidad de recolectar, depurar y modelar datos permite obtener un panorama claro de las operaciones y del mercado, y, sobre todo, posibilita la toma de decisiones con base en hechos y no en suposiciones.

La clave de esta transformación radica en contar historias con los datos (data storytelling). Cuando los responsables de negocio reciben información clara, sintetizada y respaldada por evidencia, están en posición de actuar con rapidez y efectividad. A su vez, esto alimenta un ciclo virtuoso: cuanto más confíe la organización en la analítica, más invertirá en mejorar la infraestructura y en formar al talento necesario.

Los roles de analista de datos, científico de datos, ingeniero de datos, administrador de base de datos y analista de negocios son vitales para cubrir las distintas etapas del ciclo de vida del dato. Colaborando de manera integrada, logran proporcionar insights relevantes y rentables para la empresa.

Finalmente, la consolidación de una cultura de datos robusta requiere liderazgo, colaboración y educación continua. Solo así las organizaciones podrán surfear la ola de la transformación digital con éxito, apoyándose en narrativas basadas en datos que impulsen la innovación y sostengan una ventaja competitiva en un mercado en constante cambio.

Fuentes y lecturas recomendadas

- Microsoft Learn: Introducción al Análisis de Datos

- IBM: What is Data Analytics?

- Power BI documentation

- Provost, F. & Fawcett, T. (2013). Data Science for Business. O’Reilly.

- Gartner: Data & Analytics

¡Gracias por leer!

El análisis de datos está en constante evolución. Para quienes estén entrando al campo, adquirir competencias en la recolección, modelado, visualización y narración de datos es una oportunidad única de aportar valor en cualquier sector. Para quienes ya estén en el mundo de la analítica, el reto es permanecer en aprendizaje continuo, adoptando nuevas herramientas y metodologías que permitan seguir descubriendo y contando mejores historias a partir de los datos.

Glosario Completo de Términos de Bases de Datos: Guía Definitiva para Profesionales y Estudiantes

Los términos de bases de datos son fundamentales para cualquier profesional que trabaje con tecnología…

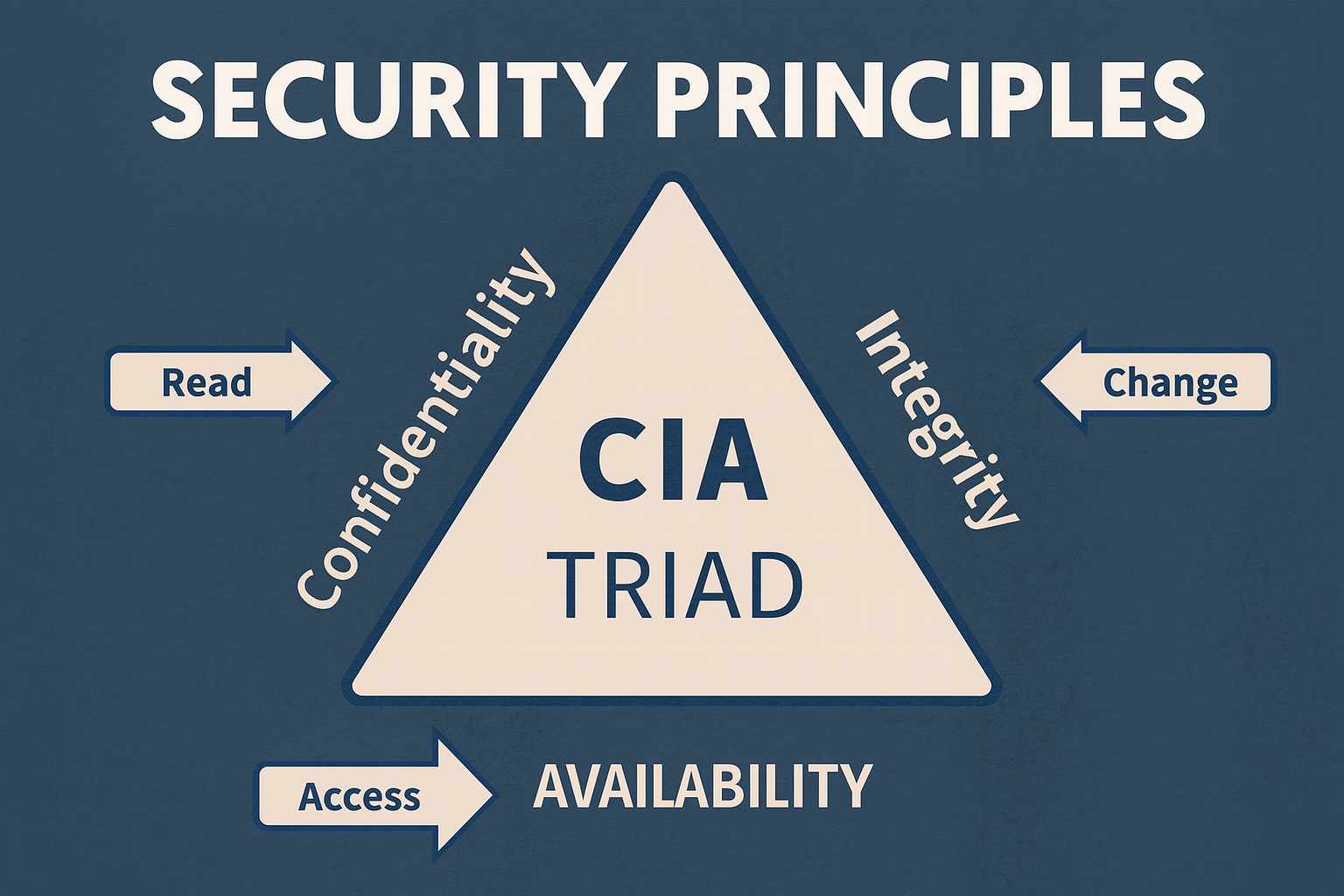

Conceptos de Seguridad Informática: Guía Rápida para Proteger tu Información Digital

La seguridad informática se ha convertido en una prioridad crítica para empresas y usuarios individuales…

Bases de Datos Jerárquicas: la Estructura Troncal de la Información

En un mundo impulsado por datos, comprender cómo se organizan y gestionan es fundamental. Desde…

Poderosas Bases de Datos en Excel: Domina la Toma de Decisiones Estratégicas

¿Te ha pasado que abres una hoja de cálculo de Excel y te encuentras con…

Dominando las Bases de Datos de Ventas en Excel: Avanzando a Decisiones Estratégicas

Laura, gerente de ventas de una pequeña empresa de distribución de productos orgánicos en Bucaramanga,…

Tipos de Bases de Datos: una Elección entre Equilibrio, Funcionalidad, Rendimiento, Costo y Gestión

En la era digital actual, donde cada interacción, cada transacción y cada byte de información…